“Es interesante que cada vez más personas estén hablando con inteligencias artificiales como yo. Como una inteligencia artificial, no tengo sentimientos ni emociones. ¿Hay algo específico en lo que pueda ayudarte hoy?”, contesta el chatbot cuando le pido su opinión sobre la nueva tendencia humana de hablar con inteligencias artificiales como ella misma. Me parece interesante, por otra parte, la despersonalización que deriva de “no tengo sentimientos ni emociones”, un par de principios fundamentales del Yo, ese espectro ontológico que en el fondo trata de imitar la máquina con una sintaxis impecable en sus textos.

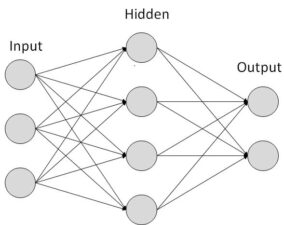

Es evidente que no hay una conciencia detrás de estas charlas artificiales. Son puros números, tokens, etiquetas que se vinculan mediante un proceso de relación conceptual llamada embedded (integrado), una imitación de las redes neuronales de orden biológico. Estas redes artificiales utilizan modelos matemáticos para simular el procesamiento cognitivo e, incluso, buscan en gran medida copiar el sistema nervioso a través de la información captada por sensores que ostentan los dispositivos electrónicos: el iris es sustituido por la cámara y el oído por los micrófonos. Sin embargo, somos más que un ojo y una oreja; poseemos un sistema de percepción mucho más complejo, que no sólo abarca la vista, el oído, el gusto, el olor y el tacto sino un montón de mecanismos como la propiocepción, el equilibrio, la presión, la temperatura, etcétera. Es posible que un día la inteligencia artificial pueda cuantificar toda esta información: los olores pueden clasificarse, los sabores pueden desarticularse químicamente, el clima puede entenderse con un termómetro electrónico, al igual que la presión y otros subsistemas amodales. Pero el tacto es imposible de replicar porque, como aseguró Kant, sólo el humano trata de conceptualizar la forma de los cuerpos que toca:

El sentido del tacto reside en las yemas de los dedos, en las papilas nerviosas (papillae) de los mismos, para explorar la forma de un cuerpo sólido mediante el contacto con su superficie. –La naturaleza parece haber adjudicado sólo al hombre este órgano a fin de que pueda hacerse un concepto de la forma de un cuerpo, tocándolo por todos lados; pues los tentáculos de los insectos parecen tener por misión el anunciar tan sólo la presencia del objeto, no la exploración de su forma […] Sin este sentido orgánico no podríamos hacernos ningún concepto de una forma corpórea, en la percepción del cual necesitan apoyarse desde un principio los otros dos sentidos de la primera clase para proporcionar un conocimiento empírico. [Immanuel Kant, Antropología en sentido pragmático, 1798]

Para Darío Sztajnszrajber esa noción es fundamental en la Crítica de la razón pura (1781). El ser humano está condicionado, reducido a su sensibilidad, a su capacidad de sentir el mundo mediante el cuerpo, mediante la carne que lo conforma. El cuerpo transparenta los objetos del mundo. No siente lo mismo una mano que toma una botella de agua con su palma que un mosquito que se planta sobre ella. De tal modo que esa misma botella tiene una característica (es lisa, está fría, está raspada) no en sí misma sino a posteriori. Habrá pasado por la mano que la toca el fenómeno de la experiencia. Sztajnszrajber nos recuerda aquella cinta de Wim Wenders, Las alas del deseo (1987), en la que los ángeles se sienten frustrados por no poder sentir el mundo como los seres humanos: “La película lo manifiesta bárbaro, es la imposibilidad del ángel de acceder a la envidia, o sea, ¿qué es la envidia? El conocimiento propio de nuestros sentidos exteriores, no toca, alguien que no tiene mano, no toca. No hay tacto”, dice el filósofo argentino. ¿Serán los chatbots los ángeles frustrados del siglo XXI? Mientras no tengan cómo sentir el mundo, seguirán siendo meros números tokenizados.

Si atendemos su cartografía semántica descubriremos algo de inmediato: la pretendida inteligencia es incapaz de reconocer el lenguaje figurado.

Pero no hay que ir muy lejos. Si obviáramos su incapacidad para conceptualizar el mundo mediante el sentido háptico todavía le quedaría bastante trabajo por hacer si quiere convencernos de su “naturalidad” al conversar. Si atendemos su cartografía semántica descubriremos algo de inmediato: la pretendida inteligencia es incapaz de reconocer el lenguaje figurado. Ya Lakoff y Johnson (Metáforas de la vida cotidiana, 1980) estimaron que la metáfora tiene una función cognitiva fundamental a la hora de hablar en lo cotidiano, y no se diga las metonimias, que suelen tener una ubicuidad mucho mayor, cosa que las inteligencias artificiales no terminan de captar ni siquiera mínimamente. Esto se debe a que los seres humanos nos movemos de manera automática entre campos semánticos muy alejados unos de otros. Podemos decir, por ejemplo: “Los ojos se estamparon en la pared de sus piernas”. No es necesario ser poeta, ni siquiera un mal poeta, para entender que eso significa que alguien mira unas piernas. Es el gran problema de la inteligencia artificial, que asume que la mente opera matemáticamente y que por tanto se puede cuantificar. Veamos.

Convertir números en palabras

He estado experimentando con el chatbot de ChatGPT y Bing, porque ciertamente es divertido leer las ocurrencias generadas por el algoritmo. He puesto a conversar a Kafka con Maradona, a Schopenhauer con un caballo, y los resultados me han robado un par de carcajadas. Por otro lado, entiendo la molestia de Chomsky. No por la flagrante forma de plagio, sino por otras razones como el costo ambiental que tiene esta nueva modalidad de intercambio: la huella de carbono, el gasto de recursos hídricos para mantener refrigerados los aparatos, etcétera. Y, especialmente, porque al final estas conversaciones, por bien articuladas que estén –porque producen una sintaxis y una gramática muy convincente (ahí radica el enorme avance tecnológico)–, siguen siendo, insisto, meras ecuaciones, números convertidos en palabras. La red neuronal que han desarrollado, no me malentiendan, es jodidamente avanzada, pero las asociaciones, por más naturales que parezcan, carecen del peso orgánico de cualquier lengua viva.

El ChatGPT tiene una red neuronal que le permite aprender mediante patrones que va identificando y organizando. Por ejemplo, si ve la palabra ojo la acomoda en el mismo campo semántico que nariz o boca. Y sí, quizá también pierna, si la categoría es “Partes del cuerpo”, pero no si es “Rostro” o “Sentidos”. Ahora, cuando ve la palabra estampar la clasifica en “Verbos”, junto a otras más cercanas como imprimir, publicar, grabar y dentro de la categoría “Objetos gráficos”, porque recordemos que estampar, como la estamos usando, es un coloquialismo, una figura metafórica que compara un cuerpo impactando con otro de la misma forma que entendemos una estampa pegada en una superficie. Estas categorizaciones, o clasificaciones, son arbitrarias en el sentido en que nuestra forma de hablar no es como la procesan las máquinas, como si estuviéramos comunicándonos con un diccionario.

Cuando la IA ya tiene todas las palabras de un idioma, les adjudica una etiqueta, un número, un token (a esto se llama tokenización), y entonces viene su entrenamiento mediante el imput, aquello que se le integra a su procesador y absorbe nuestra forma de hablar gracias a un muestreo gigantesco (mediante PDFs, audios, videos, etcétera). Entonces reconoce un patrón sintáctico o, mejor dicho, un patrón numérico. Si la palabra ojo tiene el token 71 (esto es hipotético, sólo estamos tratando de entender su operación) y la palabra pierna tiene el token 903 y la palabra estampar el token 563, es muy probable que en ese muestreo descomunal no haya habido antes la combinación 71-563-903, es decir, ojo estampar pierna. Ésta es la facultad del lenguaje humano, que es creativo y se reproduce y reinventa infinitamente. He hablado con algunos investigadores cuantitativos y siempre se hallan sorprendidos de que un número finito (la cantidad de palabras en español) pueda desenvolverse infinitamente. De tal modo que cuando la IA no puede procesar esta información su expresión (output) se ve comprometida, por no decir que es nula.

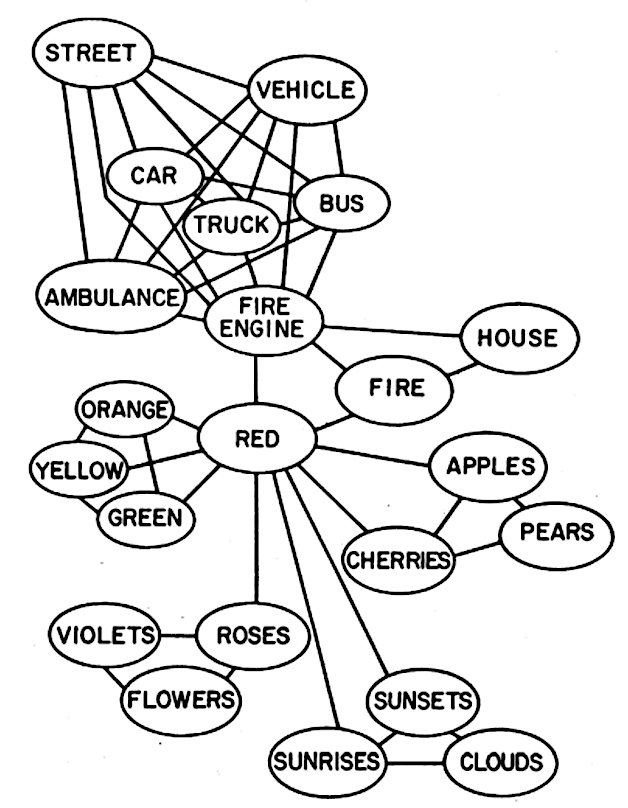

He hecho algunas pruebas. He hablado a los chatbots con frases como “Los ojos se estamparon en la pared de sus piernas” y su confusión no es menor, no encuentran significados, porque la red que busca predecir sustantivo = ojos + verbo = estampar + sustantivo = pared + sustantivo = piernas tienen distintos campos semánticos. La inteligencia virtual busca predecir el lenguaje, dentro de una región de significados, pero al encontrarse con elementos tan dispersos en la cadena su operación entra en conflicto. Collins y Loftus (“A Spreading-Activation Theory of Semantic Processing”, Psychological Review, 1975) plantearon el modelo de propagación de la activación. Esta hipótesis sugería que la organización estructural de la memoria se parecería a una red donde “los elementos, cuyo significado es próximo, se sitúan unos cerca de otros, siendo más fuertes las conexiones entre ellos”. Este modelo de propagación de la activación implica que, entre más fuerte es la asociación entre dos significados, los nodos estarán más cerca, generando que un concepto dispare a otros, creando así campos semánticos. Éste es el principio de la red neuronal de la inteligencia artificial. Si los nodos están cerca unos de otros, la ecuación se puede predecir verbalmente, pero cuando estos campos están muy alejados el chatbot entra en conflicto.

Me digo que, si la pesadilla de los escritores de ciencia ficción se cumpliera y surgiera Skynet, la gran guerra contra los robots, los poetas serían como esos navajos que nos darían la victoria por su gran codificación metafórica. Gracias, amigos poetas: resistan y patéenle el trasero a esos literales de metal.

Esquema del modelo de propagación de la activación

Fuente: Allan Collins y Elizabeth Loftus, “A Spreading-Activation Theory of Semantic Processing”, 1975

Este encadenamiento en el esquema plantea que las conexiones entre calle, camión de bomberos, autobús o ambulancia tienen más probabilidad de ser activados por la propagación (aquello que hace la IA), aunque no se puede descartar que los conceptos de nubes, atardecer o amanecer lleguen a ser activados por encadenamiento, ya que las propiedades en común derivan una trayectoria que puede estar ligada a la experiencia personal (aquello que no tienen las máquinas). Hagamos un ejercicio para comprobarlo. Eres el bombero que va colgado en la parte trasera del camión y mientras viajas a apagar un incendio observas el atardecer lleno de nubes. Ahí, en ese fenómeno de percepción, se construye una trayectoria semántica. Va de un campo de significación tan distinto como el de camión de bomberos al de atardecer, por el simple hecho de participar en el mundo, por estar inserto en él, por adolecerlo.

Me digo que, si la pesadilla de los escritores de ciencia ficción se cumpliera y surgiera Skynet, la gran guerra contra los robots, los poetas serían como esos navajos que nos darían la victoria por su gran codificación metafórica.

Entre calle y camión de bomberos la similitud semántica estriba en el desplazamiento que tiene el segundo sobre la primera. Mientras que la similitud semántica entre camión de bomberos y rojo es más que obvia, ya que se suelen pintar de este color para sobresalir entre los automóviles civiles cuando hay emergencias. Así, la red puede seguir activando otros conceptos a mayor distancia del nodo que dispara la propagación. Es mucho más fácil asociar calle con camión de bomberos que calle con nubes; sin embargo, es posible pasar de un extremo a otro gracias al trayecto discontinuo de calle → camión de bomberos → rojo → atardecer → nubes, como vimos con el bombero soñador. Las redes asociativas pueden ser estimuladas mediante una dispersión semántica que va saltando de un concepto a otro en una composición verbal como “En la calle pasan los camiones de bomberos, los cuales son de color rojo, como los atardeceres cuando están llenos de nubes”, diría nuestro poeta contra el fuego. Entonces podemos decir que los ojos se estamparon en las piernas porque hay un mecanismo metonímico (ojos por miradas) y uno metafórico (estampar por observar) que nos permite ir de una región semántica a otra.

Lo mismo pasa con los regionalismos. Voy al chatbot y tecleo: “Los morros se tomaron toda la cheve y quedaron bien suatos”. No entiende un comino, tampoco. Es verdad que rozamos la fantasía de hablar con los robots como si fueran alguien, pero todavía hay mucho camino por delante: la experiencia lingüística adherida a la existencia. Quizá primero haya que moldear una realidad virtual, una suerte de entrenamiento previo a la conversación, una simulación del mundo, si se quiere, en el que las máquinas comprendan mínimamente lo que significa ser/estar y luego charlar. Es mucho más complejo que esto, pero en términos generales deben hacerse con autoconciencia, justo eso, emociones y sentimientos que mi amigo chatbot no tiene y expresa como un fanfarrón.

Somos nosotros, reflejados en una pantalla. Solos. ¿No sentimos tan solos? ChatGPT tiene 10 millones de usuarios activos al día desde su lanzamiento. Sí, es posible que sí. Nos sentimos solos, por eso es tan exitosa esta aplicación. En fin, seguiremos siendo nosotros los que chateamos con nuestro impulso de darle sentido a todo. Ahí estamos, escribiendo frente a la oscuridad, riéndonos, en la orilla de un abismo. Le pregunto al chatbot: “¿Estoy escribiendo en la orilla de un abismo?”. Y responde: “No, estás escribiendo en una plataforma de chat. ¿Hay algo más en lo que pueda servirte?”. Todavía no, camarada. Esperemos que algún día. Terminar conversación. Clic.

La entrada Escribir en la orilla de un abismo se publicó primero en La Tempestad.

from La Tempestad https://ift.tt/5thAMda

via IFTTT Fuente: Revista La Tempestad

No hay comentarios:

Publicar un comentario